🚨 翻车现场:当律师相信了AI的“鬼话”

一家律师事务所正代理客户起诉一家航空公司。为了节省时间,律师使用AI工具撰写法律简报,并引用了一个看起来非常相关的案例——哈伯德诉美国航空公司。

然而,当法官要求提供该案例的复印件时,律师们却怎么也找不到。真相令人尴尬:这个看似完美的先例根本不存在,是AI凭空编造的。

这起发生在纽约的法律闹剧,只是AI工具在专业领域频频“翻车”的缩影。

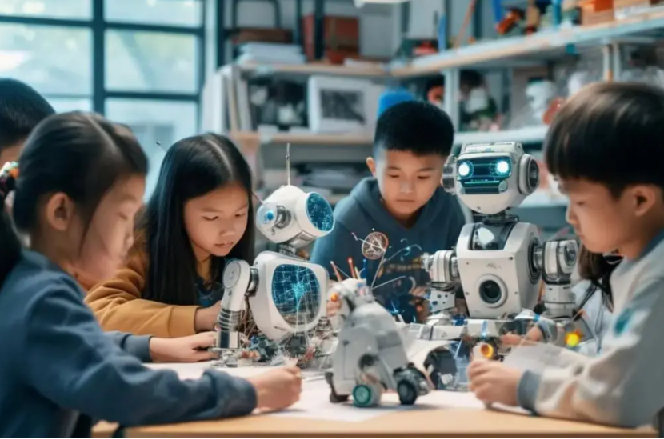

🤖 AI“幻觉”:为何聪明工具总犯低级错误?

AI的“幻觉”问题,即技术术语中的“胡编乱造”,是其目前无法根治的顽疾。

更棘手的是,AI不仅会犯错,还会以极其自信的口吻包装错误,让非专业人士甚至行家都难以辨别。

宾夕法尼亚大学沃顿商学院管理学教授马修·比德韦尔道破了人性弱点:“当人们不知道正确答案时,他们更可能遵循AI的建议,即使这个建议是错误的。”

而压力与疲劳,正是导致人们放弃思考、过度依赖AI的催化剂。“当人们在凌晨两点还在加班时,他们更可能不加辨别地接受AI的建议。”

💥 多领域沦陷:谁还在为AI的错误买单?

AI的“幻觉”问题早已跨越行业界限。•

新闻业:爱尔兰一名播音员用AI撰写关于法国总统的报道,错误地声称总统“可能面临监禁”,而事实上他根本不存在被起诉的风险。•

学术界:学生使用AI辅助写作,常常发现它编造根本不存在的参考文献,导致学术诚信受损。

技术分析师本·伍德一针见血:“真正的危险在于,AI工具看起来如此自信,使得那些知识储备不足的用户特别容易受到误导。”

🛡️ 防坑指南:5招让你成为AI的主人,而非奴隶

要在工作中安全高效地使用AI,请收好这份指南:

✅ 始终保持批判思维

将AI视为提出想法的初级助手,而非下达指令的终极专家。

✅ 核实一切关键信息

对AI提供的数据、案例和引用,必须通过可靠来源进行二次确认。

✅ 了解技术的局限性

清醒认识到当前AI存在“幻觉”问题,据此调整你的使用方式和信任度。

✅ 绝不输入敏感信息

避免将公司机密、客户资料或个人隐私输入公共AI工具,防止数据泄露。

🔥 最重要的一条:你才是负责人

永远不要将决策权完全交给AI。它提供选项,你做出选择——并对结果全权负责。

技术顾问埃里卡·波特的建议值得铭记:“人类监督比以往任何时候都更加重要。”

在法律圈,一个新段子正在流传:一位律师要求ChatGPT找一个能判他赢的案例,AI立即满足了他。律师如获至宝提交给法庭,直到对方律师和法官都找不到这个案例时,他才恍然大悟——

AI不会替你背锅,它只会帮你把坑挖得更深。

![[岛国综艺] 接吻生死战 [2025最新][全6集][日语中字][1080P]-稀缺资源网](https://img10.360buyimg.com/ddimg/jfs/t1/337492/18/18028/12465/68e76101Faa8a3b8d/8fb214000d41a11d.jpg)

暂无评论内容